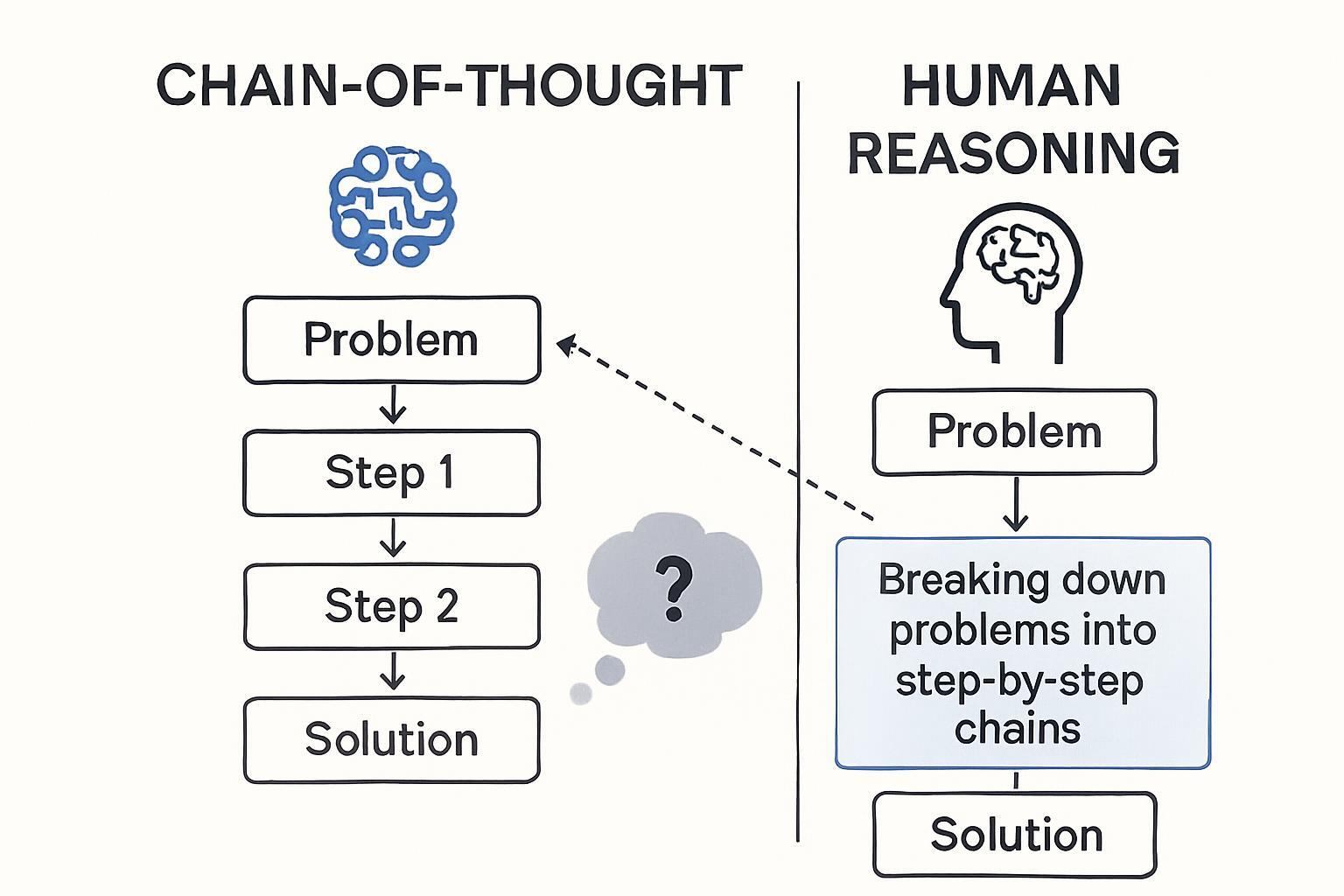

Los modelos de IA que utilizan cadenas de pensamiento (Chain of Thought) han generado expectativas sobre capacidades de razonamiento similares al humano. Sin embargo, investigaciones recientes desafían esta suposición, revelando que estos procesos no representan razonamiento genuino sino imitaciones superficiales del pensamiento humano.

Qué son las cadenas de pensamiento en IA

Los métodos de cadena de pensamiento permiten a los modelos de IA desglosar problemas complejos en pasos secuenciales más pequeños. Esta técnica simula la forma en que los humanos abordan problemas difíciles: paso a paso, mostrando el trabajo realizado por la máquina.

- Transparencia en el procesamiento contextual de información

- Capacidad de abordar problemas de múltiples etapas

- Mejores resultados en tareas de razonamiento matemático y lógico

- Explicaciones detalladas del proceso de toma de decisiones

Los hallazgos que cambian la perspectiva

La investigación de Anthropic y otros equipos revela limitaciones fundamentales en estos sistemas. Los estudios demuestran que las cadenas de pensamiento pueden estar realizando racionalización post-hoc en lugar de razonamiento genuino.

Principales problemas identificados

- Falta de fidelidad: Los pasos mostrados no siempre reflejan el proceso real de decisión del modelo

- Sensibilidad al contexto: Pequeños cambios en el orden de premisas generan resultados inconsistentes

- Dependencia de tamaño: Solo funcionan efectivamente en modelos extremadamente grandes

- Generalización limitada: No se adaptan bien a diversos tipos de problemas

Implicaciones para la automatización empresarial

Estos hallazgos tienen consecuencias directas para empresas que implementan automatización inteligente basada en modelos de razonamiento. Los equipos que confían en estas capacidades para procesos críticos deben reconsiderar sus estrategias.

Áreas de impacto inmediato

- Análisis de datos complejos: Los modelos pueden generar explicaciones convincentes pero incorrectas

- Optimización de procesos: Las decisiones automatizadas requieren validación humana adicional

- Integración con herramientas: Plataformas como n8n o Make necesitan considerar estas limitaciones

- Flujos de trabajo empresariales: Mayor necesidad de supervisión en decisiones críticas

Alternativas en desarrollo

La comunidad investigadora está explorando enfoques alternativos para superar las limitaciones del Chain of Thought tradicional.

- Tree of Thoughts: Permite explorar múltiples caminos de razonamiento simultáneamente

- Razonamiento neuro-simbólico: Combina redes neuronales con técnicas de razonamiento simbólico

- Evaluación de fidelidad: Nuevos métodos para verificar la autenticidad del proceso de razonamiento

Recomendaciones prácticas

Para organizaciones que utilizan modelos de IA con capacidades de razonamiento, es crucial ajustar las expectativas y implementar salvaguardas apropiadas. La IA generativa aplicada puede seguir siendo valiosa, pero requiere un enfoque más cuidadoso en su implementación.

La investigación sugiere que el procesamiento contextual actual está lejos de emular el razonamiento humano genuino. Las empresas deben mantener la supervisión humana en decisiones críticas mientras se desarrollan arquitecturas de razonamiento más robustas. El avance hacia una verdadera inteligencia artificial requerirá enfoques fundamentalmente nuevos, no simplemente modelos más grandes con las mismas limitaciones.