Google ha presentado LMEval, un nuevo framework de código abierto diseñado específicamente para evaluar y comparar el rendimiento de modelos de lenguaje y multimodales de manera consistente. Esta herramienta representa un avance significativo para desarrolladores y organizaciones que necesitan métricas fiables para medir las capacidades reales de diferentes modelos de IA en entornos prácticos.

Una solución al problema de la evaluación fragmentada

Hasta ahora, el ecosistema de evaluación de modelos de IA ha estado caracterizado por la fragmentación y la falta de estándares unificados. LMEval surge como respuesta directa a este desafío, proporcionando una plataforma común que permite:

- Realizar comparativas precisas entre diferentes modelos de lenguaje y multimodales

- Aplicar metodologías consistentes para medir capacidades específicas

- Facilitar la evaluación transparente mediante métricas compartidas y reproducibles

- Integrar flujos de trabajo estandarizados para pruebas de rendimiento

Características principales de la plataforma

El framework LMEval de Google se caracteriza por varios elementos distintivos que aportan valor a los equipos de desarrollo e investigación en IA:

- Arquitectura modular: Permite personalizar componentes específicos del proceso de evaluación según las necesidades del proyecto

- Soporte multimodal: Capacidad para evaluar modelos que procesan tanto texto como imágenes, video y otros formatos

- Métricas estandarizadas: Conjunto unificado de criterios de evaluación que facilitan comparativas objetivas

- Código abierto: Disponible en GitHub para fomentar la colaboración y mejora continua por parte de la comunidad

Impacto en el desarrollo de modelos de IA

La introducción de LMEval tiene implicaciones significativas para el sector de la inteligencia artificial aplicada. Para las empresas y equipos de desarrollo que trabajan con modelos de lenguaje, esta herramienta ofrece:

- Mayor objetividad en la selección de modelos para casos de uso específicos

- Reducción del tiempo necesario para evaluar la idoneidad de diferentes sistemas de IA

- Capacidad para identificar fortalezas y debilidades de cada modelo en diversos escenarios

- Mejora en la transparencia y confiabilidad de las soluciones basadas en IA

Integración con el ecosistema de herramientas de IA

Google ha diseñado LMEval para que funcione de manera eficiente dentro del ecosistema existente de herramientas de desarrollo de IA. La plataforma permite una integración sencilla con flujos de trabajo actuales y proporciona interfaces claras para conectar con diferentes frameworks de aprendizaje automático.

Los desarrolladores pueden implementar estas evaluaciones como parte de sus procesos de integración continua, permitiendo detectar regresiones o mejoras en el rendimiento de sus modelos de forma automatizada durante el ciclo de desarrollo.

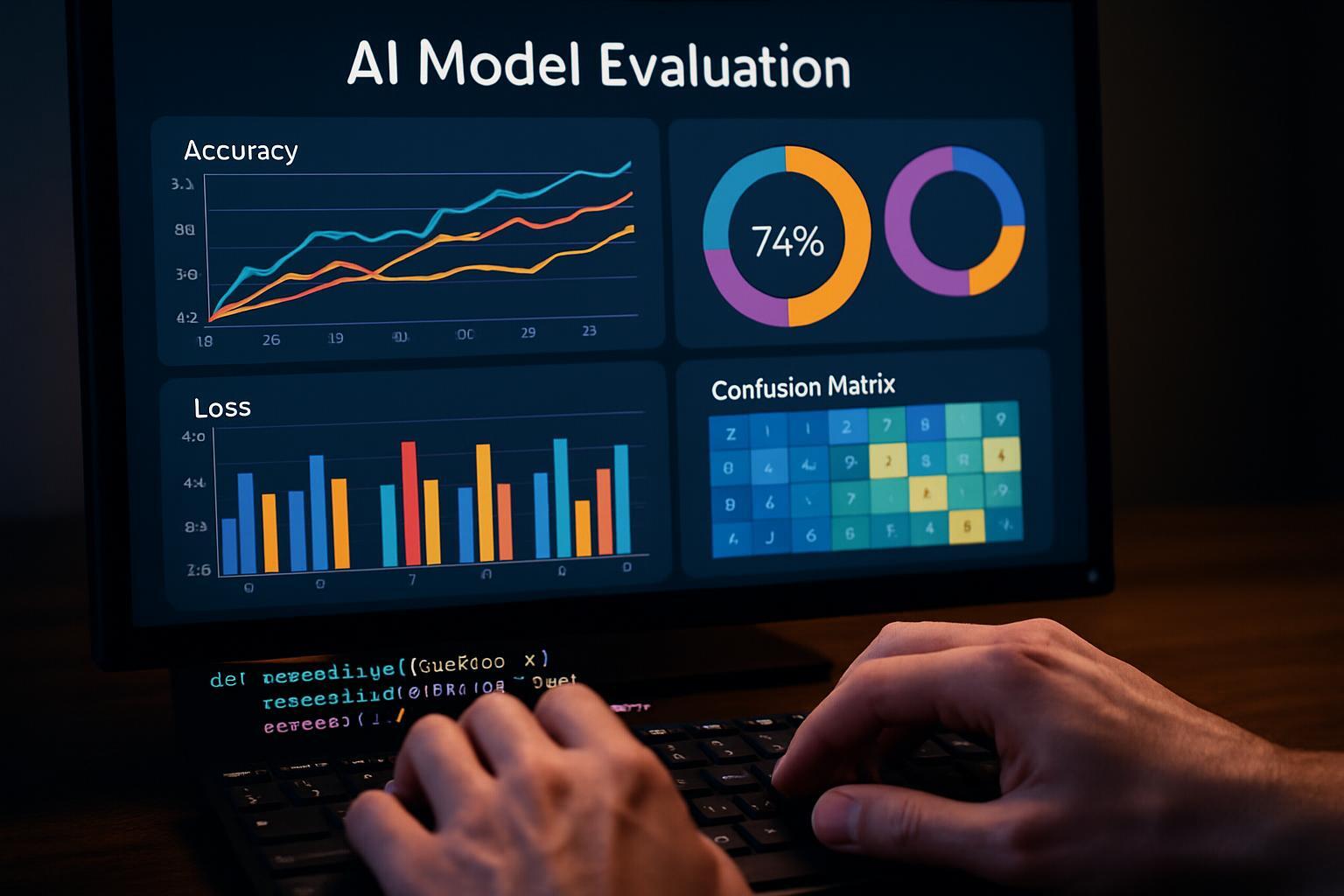

Análisis detallado mediante visualizaciones interactivas

Entre las características destacadas de LMEval se encuentra su capacidad para generar detallados informes visuales que facilitan la interpretación de resultados complejos. Estas visualizaciones permiten identificar patrones de rendimiento y áreas específicas donde cada modelo destaca o necesita mejoras.

Conclusión: Un paso hacia la estandarización en evaluación de IA

La presentación de LMEval por parte de Google representa un avance importante hacia la estandarización en la evaluación de modelos de lenguaje e inteligencia artificial multimodal. Esta herramienta de código abierto no solo simplifica el proceso comparativo, sino que establece bases más sólidas para medir objetivamente el progreso en el desarrollo de sistemas de IA cada vez más sofisticados.

Para empresas y equipos que buscan implementar soluciones de automatización inteligente basadas en modelos de lenguaje, LMEval ofrece un recurso valioso que permite fundamentar decisiones técnicas en datos comparativos confiables y metodologías reproducibles.