Un nuevo estudio de la Universidad de Oxford revela una paradoja inquietante en la aplicación de la inteligencia artificial a la medicina: mientras los grandes modelos de lenguaje (LLM) demuestran capacidades impresionantes en exámenes médicos teóricos, su efectividad disminuye drásticamente cuando interactúan con pacientes reales. Esta brecha entre el potencial y la aplicación práctica representa un desafío crítico para la implementación de IA en sistemas de salud ya sobrecargados.

Brillantes en teoría, limitados en la práctica

El ensayo controlado aleatorio, conducido por el Instituto de Internet de Oxford con 1,298 participantes del Reino Unido, evaluó modelos avanzados como GPT-4o de OpenAI, Llama 3 de Meta y Command R+ de Cohere. Los participantes debían identificar posibles causas para sus síntomas simulados y seleccionar el curso de acción adecuado.

Los resultados fueron reveladores:

- GPT-4o identificó condiciones relevantes en el 94.7% de los casos y recomendó la acción correcta en el 64.7% cuando se le consultó directamente

- Llama 3 alcanzó una precisión del 99.2% en la identificación de condiciones

- Command R+ logró un 90.8% de precisión en diagnósticos

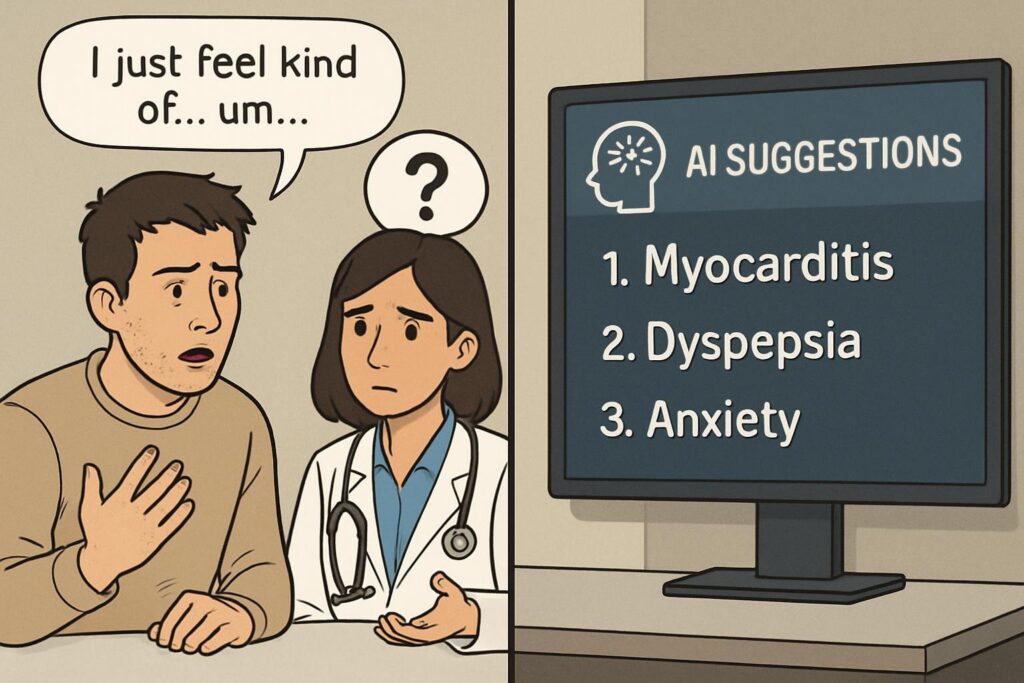

Sin embargo, cuando los usuarios comenzaron a interactuar con estos modelos, los resultados se deterioraron significativamente. Con asistencia de LLM, los participantes identificaron una condición relevante en solo hasta el 34.5% de los casos, por debajo del grupo de control (47%) que realizó su propia investigación mediante búsquedas tradicionales.

El factor humano como cuello de botella

El estudio atribuye esta caída de rendimiento no a las limitaciones de los modelos en sí, sino a la interacción problemática entre humanos y máquinas. Los investigadores identificaron patrones preocupantes:

- Los usuarios frecuentemente proporcionaban información incompleta

- Malinterpretaban las respuestas de los modelos de lenguaje

- Seleccionaban arbitrariamente entre las múltiples opciones proporcionadas

Por ejemplo, Command R+ no pudo diagnosticar cálculos biliares cuando un participante omitió detalles sobre la ubicación del dolor. En otro caso, GPT-4o categorizó síntomas casi idénticos como una emergencia en un caso y como un dolor de cabeza menor en otro.

Los modelos típicamente sugerían un promedio de 2.2 posibles diagnósticos, pero los usuarios solo adoptaban aproximadamente 1.33 de estas sugerencias, y apenas un tercio de esas elecciones eran correctas. Este “problema de transferencia” impide que el conocimiento médico de los LLM llegue efectivamente a los usuarios.

Limitaciones de las evaluaciones en laboratorio

El estudio también cuestiona los métodos de evaluación estándar para IA médica. Aunque los LLM evaluados se desempeñaron bien en el benchmark MedQA, basado en preguntas de exámenes de licencia médica, esto no se tradujo en un mejor rendimiento durante las interacciones con usuarios reales.

Curiosamente, los usuarios simulados (LLMs actuando como pacientes) superaron a los humanos reales, pero no reflejaron con precisión el comportamiento de usuarios genuinos. Esto sugiere que las pruebas en entornos controlados no predicen adecuadamente el desempeño en el mundo real.

El camino hacia una IA médica más efectiva

Para que los LLM sean realmente útiles en medicina, el estudio concluye que necesitarán:

- Ser proactivos en solicitar información en lugar de depender de que el usuario guíe la interacción

- Comunicar recomendaciones con mayor claridad y contexto

- Adaptar sus interfaces para facilitar interacciones más naturales y completas

Los investigadores advierten que las esperanzas de utilizar LLMs para complementar sistemas de salud sobrecargados pueden necesitar reconsiderarse a la luz de estos hallazgos. El estudio subraya la importancia de realizar pruebas de usuario en el mundo real, no solo evaluaciones basadas en simulaciones.

Implicaciones para el futuro de la IA en medicina

Este estudio de Oxford representa un recordatorio importante de que la integración práctica de la IA en la atención médica enfrenta desafíos que van más allá de la capacidad técnica de los modelos. La brecha entre el rendimiento teórico y la aplicación práctica sugiere que se necesita un enfoque más holístico que considere:

- Diseño de interfaces centradas en el usuario

- Capacitación específica para profesionales médicos sobre cómo interactuar efectivamente con sistemas de IA

- Desarrollo de modelos que puedan adaptarse a las limitaciones y comportamientos humanos reales

Mientras la tecnología de IA continúa avanzando rápidamente, este estudio destaca que la interacción humano-máquina sigue siendo el obstáculo central para aprovechar plenamente su potencial en medicina, una lección que los desarrolladores y sistemas de salud deberán incorporar en sus estrategias futuras.