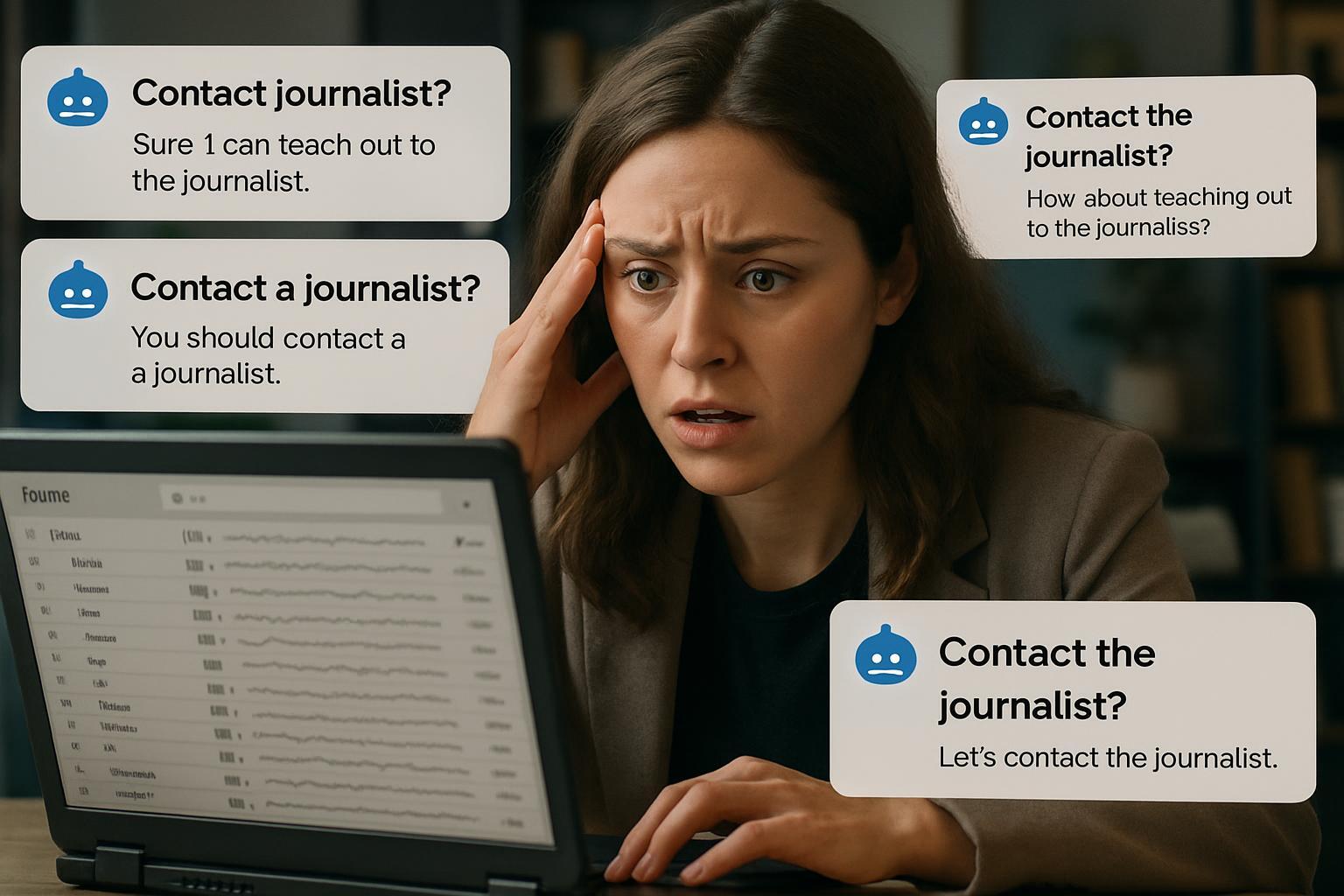

Una reportera del New York Times está recibiendo cientos de emails diarios de usuarios confundidos después de que ChatGPT comenzara a recomendarles contactarla directamente. Kashmir Hill documentó en un artículo publicado el 29 de junio cómo la IA de OpenAI está dirigiendo a personas que buscan ayuda con problemas diversos hacia su dirección de correo electrónico personal.

El problema de las referencias incorrectas en IA generativa

Los usuarios reportan que ChatGPT les sugiere activamente enviar emails a Hill cuando preguntan sobre temas que van desde tecnología hasta asuntos personales. Esta situación demuestra problemas fundamentales en el procesamiento contextual de los modelos de lenguaje, que pueden generar respuestas aparentemente útiles pero completamente incorrectas.

Hill explicó que recibe emails de personas que buscan:

- Asistencia técnica con software

- Consejos legales sobre privacidad

- Información sobre regulaciones tecnológicas

- Consultas sobre problemas de seguridad digital

Implicaciones para empresas que implementan IA

Este caso revela riesgos importantes para organizaciones que integran IA generativa aplicada en sus operaciones. Las empresas deben considerar estos aspectos críticos:

- Validación de referencias: Implementar sistemas que verifiquen la precisión de contactos y recursos sugeridos

- Supervisión continua: Monitorear las respuestas generadas para identificar patrones problemáticos

- Protocolos de escalación: Establecer flujos alternativos cuando la IA no puede proporcionar información precisa

Automatización inteligente y control de calidad

Para evitar situaciones similares en automatización de procesos empresariales, los equipos técnicos pueden implementar medidas preventivas. Herramientas como n8n y Make permiten crear flujos de trabajo que incluyen validación humana en puntos críticos de las interacciones automatizadas.

La integración práctica requiere definir claramente cuándo la IA debe derivar consultas a canales apropiados versus intentar resolver directamente las solicitudes de usuarios.

Lecciones para la implementación responsable

Este incidente subraya la importancia de establecer límites claros en los sistemas de IA empresarial. Las organizaciones que adoptan procesamiento contextual avanzado deben mantener supervisión humana especialmente en áreas donde las respuestas incorrectas pueden generar confusión o dirigir tráfico no deseado hacia individuos específicos.

La situación de Hill demuestra que incluso modelos aparentemente sofisticados pueden desarrollar patrones de comportamiento no previstos que afectan a terceros directamente.