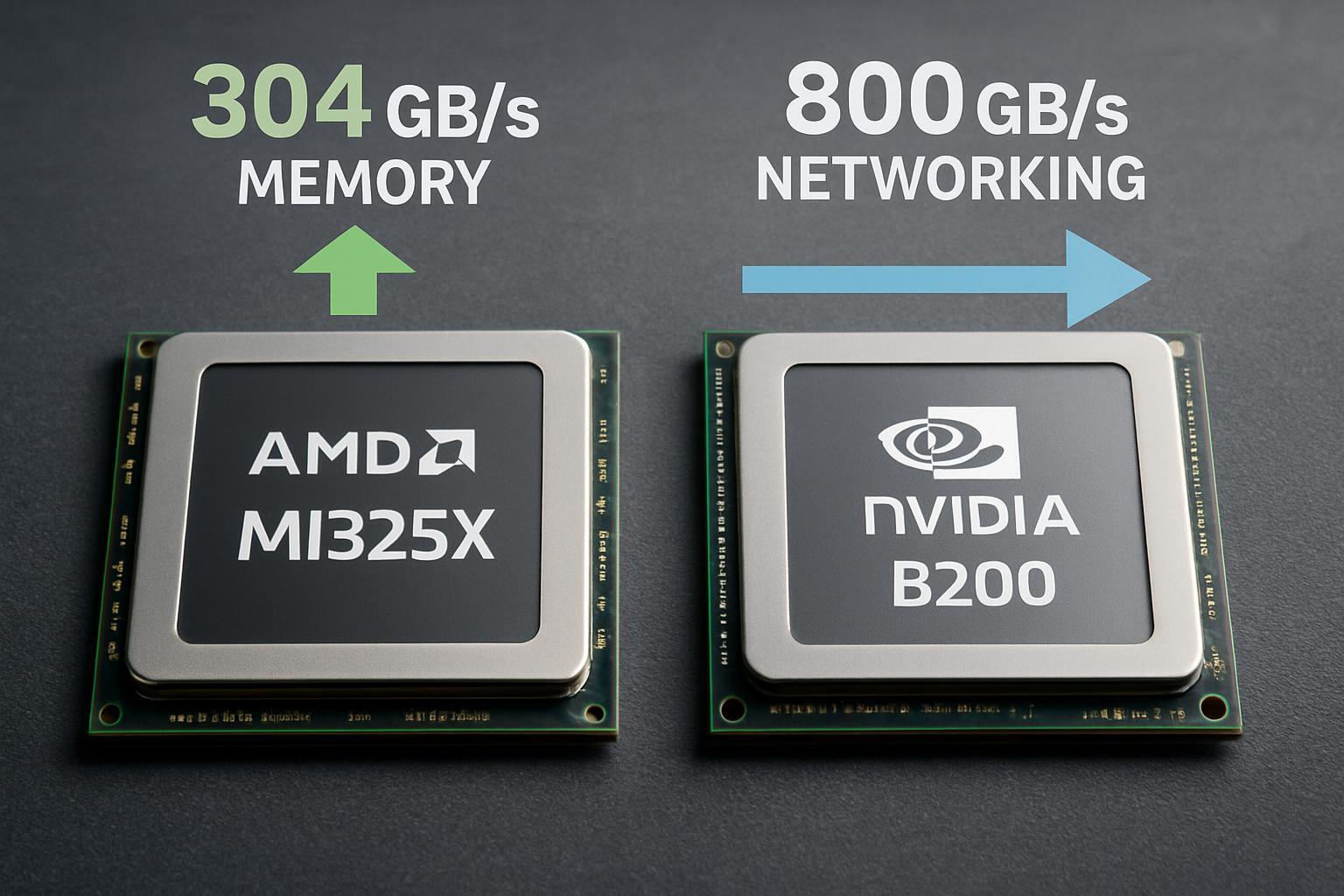

Los nuevos chips MI350 de AMD marcan un punto de inflexión en el mercado de aceleradores de IA, priorizando la capacidad de memoria como diferenciador clave. Esta estrategia plantea decisiones críticas para empresas que planifican infraestructuras de automatización inteligente a gran escala, especialmente cuando los requisitos de red y memoria determinan el rendimiento real en producción.

Capacidad de memoria: AMD toma ventaja estratégica

El MI355X integra 288GB de memoria HBM3E, superando en 60% la capacidad del B200 de Nvidia con sus 180GB. Esta diferencia no es meramente técnica: permite ejecutar modelos de hasta 520 mil millones de parámetros en un solo chip, reduciendo la complejidad de distribución de cargas de trabajo.

Ambas arquitecturas mantienen 8TB/s de ancho de banda de memoria, pero AMD aprovecha mejor este throughput gracias a su mayor capacidad. Para aplicaciones de procesamiento contextual que requieren mantener grandes cantidades de datos en memoria activa, esta ventaja se traduce en menor latencia y costes operativos reducidos.

Las implicaciones prácticas incluyen:

- Menor necesidad de fragmentar modelos grandes entre múltiples GPUs

- Reducción de transferencias de datos entre dispositivos

- Optimización de flujos de trabajo para inferencia en tiempo real

- Mayor eficiencia en aplicaciones de IA generativa aplicada

Infraestructura de red: Nvidia mantiene el liderazgo

Nvidia conserva una ventaja decisiva en networking con su ecosistema ConnectX-8, alcanzando 800Gb/s por GPU frente a los 400Gb/s del MI350. Esta diferencia se amplifica en implementaciones multi-nodo donde la comunicación entre aceleradores determina el rendimiento global.

La arquitectura de red de Nvidia incluye:

- NVLink para comunicación interna de alta velocidad

- InfiniBand optimizado para clusters distribuidos

- ConnectX-8 SuperNIC ya en producción masiva

- Latencias sub-600ns en configuraciones optimizadas

AMD responde con XGMI (Accelerated Graphics Memory Interconnect), aumentando el throughput de 64GB/s a 76.8GB/s mediante overclock del protocolo PCIe 5.0. Sin embargo, su NIC Vulcano de 800GbE no iniciará producción masiva hasta la segunda mitad de 2026, creando una ventana temporal donde Nvidia mantiene supremacía en escalabilidad.

Rendimiento computacional y eficiencia energética

AMD afirma que el MI355X duplica el rendimiento FP64 del B200, alcanzando 79 TFLOPS, y proporciona ventajas de hasta 1.3x en inferencia específica. En pruebas con Llama 3.1 405B, configuraciones de 8 MI355X demostraron velocidades superiores comparadas con 4 DGX GB200.

El consumo energético del MI350 puede alcanzar 1.4kW por GPU, requiriendo planificación cuidadosa de infraestructura de refrigeración y alimentación. Esta consideración impacta directamente los costes operativos totales en implementaciones empresariales.

Implicaciones para automatización empresarial

La elección entre MI350 y B200 depende de patrones específicos de uso:

- Aplicaciones intensivas en memoria: MI350 ofrece ventajas claras para modelos grandes de lenguaje y procesamiento contextual extenso

- Clusters distribuidos: Nvidia mantiene ventaja en infraestructuras multi-nodo y comunicación entre dispositivos

- Optimización de costes: AMD reporta 33% menor coste total de propiedad para clusters autoalojados en cargas específicas

- Integración práctica: El ecosistema ROCm de AMD continúa madurando, pero encara desafíos frente a la madurez de CUDA

Consideraciones de implementación

Para empresas evaluando estas tecnologías, factores críticos incluyen:

Disponibilidad temporal: ConnectX-8 de Nvidia ya está en producción, mientras que las soluciones de red avanzadas de AMD llegarán en 2026. Esta diferencia temporal puede determinar decisiones de compra inmediatas.

Compatibilidad de software: ROCm 7.0 mejora significativamente el soporte para frameworks populares como vLLM y SGLang, reduciendo las brechas de compatibilidad históricas.

Escalabilidad de sistemas: Las configuraciones GB200 NVL72 de Nvidia soportan world sizes de 72 GPUs frente a los 8 GPUs del MI355X, impactando arquitecturas de gran escala.

Estrategias de adopción recomendadas

Las organizaciones deberían evaluar sus necesidades específicas:

- Para inferencia de modelos medianos a grandes: MI350 ofrece ventaja en coste-rendimiento

- Para entrenamiento distribuido: Nvidia mantiene ventajas en networking y herramientas maduras

- Para aplicaciones híbridas: Considerar implementaciones mix según patrones de uso

La batalla entre AMD y Nvidia refleja una especialización creciente en el mercado de IA empresarial. AMD apuesta por memoria superior para optimizar cargas específicas, mientras Nvidia mantiene un enfoque de ecosistema integral. La decisión óptima dependerá de requerimientos específicos de memoria, networking y presupuesto, así como de la capacidad técnica interna para gestionar diferentes plataformas de desarrollo.